Capitolo 4. Nozioni di Sistemi informatici. Unità di misura nella Cultura Digitale

|

Unità di misura nella memorizzazione dei dati informatici

Ogni qual volta ci si appresta ad acquistare un dispositivo digitale, un computer, un lettore MP3, come anche un tefono cellulare di ultima generazione o un servizio di connessione ad internet, leggiamo nelle caratteristiche del prodotto una lista di informazioni tecniche descrittive. Megabyte, Gigabyte, Hertz, KB/s, Pixel e Megapixel, DPI vanno a rappresentare le unità di misura nell’informatica in uso nella Cultura digitale e contraddistinguono le valenze di uso di un dispositivo digitale come, ad esempio, la capacità di archiviazione di dati digitali e la loro velocità di calcolo. |

|

BIT: l’unità di misura del dato informatico.

Il concetto di Bit è stato introdotto nel 1948 con la Teoria dell’Informazione di Claude Shannon e rappresenta l’Unità di misura elementare di un’informazione che viene trattata da un calcolatore elettronico. In programmazione informatica viene utilizzata come unità di misura un’unità più grande, il Byte, che rappresenta, dunque, l’unità di misura di base dell’informatica. |

|

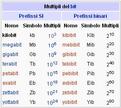

Per comodità di calcolo, mantenendo una certa affinità con il sistema metrico decimale, i multipli del byte vengono generalmente arrotondati a potenze di 2 (benché questo sia formalmente inesatto), invece che di 10. Dunque il calcolo dei multipli dei Byte diventa nell’uso comune:

Già da qualche anno, avere a disposizione singole unità di archiviazione di dati della capacità di centinaia di GB è diventato economico. Per questo, l’installazione sul proprio home computer di due hard disk da 160 GB consente una capacità di archiviazione di dati per un ammontare complessivo di quasi 500 miliardi di Bit. Per rendere comprensibile l’ordine di grandezza: 1 TeraByte di memoria di massa consente di archiviare informazioni digitali equivalenti a circa 300 ore di filmati; in 1 TB vengono archiviati circa 1400 CD-Rom o 212 DVD. Per fare un paragone con la carta stampata, un CD-Rom può contenere l’equivalente informazione digitale di circa 1000 libri stampati. Per cui, oggi, nel 2007 con una modica spesa di circa 250 euro necessari ad acquistare 2 hard disk da 250 MB, si ha la possibilità di archiviare l’equivalente di 1.400.000 libri. Basti pensare che la Biblioteca Vaticana figura 4.12 custodisce quasi due milioni di libri! |

|

Velocità nella elaborazione dei Dati

In informatica, caratteristiche e parametri del concetto di velocità vengono presi in diversa considerazione in funzione del componente interno che va a costituire un elaboratore, una periferica esterna o dell’interconnessione tra diversi computers collegati in rete. Nel caso dei componenti interni di un elaboratore, l’unità di misura che ci interessa è l’Hertz (simbolo Hz), che nell’elettromagnetismo (la branca della fisica che studia i fenomeni di natura elettrica) misura la frequenza. Un Hz significa un “evento al secondo”. Quindi un maggior numero di Hz significa un maggior numero di eventi che avviene in un secondo di tempo. In elettronica, maggiore è la velocità in Hz di un processore (CPU) costruito sulla stessa architettura progettuale, maggiore è la sua velocità di calcolo dei dati informatici che chiediamo di elaborare al computer. Per esempio, un processore Intel Pentium 4 con velocità 2,7 GHz è meno veloce di un Intel Pentium 4 con velocità 3,0 GHz. Lo stesso vale per la memoria Ram/Rom e per tutti gli altri componenti che riportano l’unità di misura [n]Hz. |

|

Velocità nella trasmissione dei Dati

Un’informazione digitale, oltre ad essere elaborata, deve essere trasmessa sia tra i vari componenti interni del computer e le sue periferiche esterne che tra diversi elaboratori collegati tra di loro per la condivisione delle informazioni tra vari utenti. |

|

Il Kilobit per secondo (abbreviato Kbit/s o Kbps) è l'unità di misura che indica la capacità (dunque la velocità) di trasmissione dei dati. Un kilobit per secondo corrisponde ad una velocità di trasmissione di dati pari a 1.000 bit al secondo. Attenzione a non confondersi con il Byte che, come abbiamo visto, corrisponde a 8 Bit. Ciò significa, quindi, che con una velocità di trasmissione di un Kbps, si ha la possibilità di trasferire dati equivalenti a 125 Byte al secondo, oppure 7,5 KB al minuto, oppure 0,45 GB all’ora.

Multipli del Kbps sono: - Megabit per secondo (abbreviato Mbit/s o Mbps) - Gigabit per secondo (abbreviato Gbit/s o Gbps) - Terabit per secondo (abbreviato Tbit/s o Tbps) Nella costruzione di connessioni tra computers la capacità di trasmissione dei dati e la conseguente velocità è una caratteristica molto importante: Maggiore è la capacità di trasmissione, più veloce sarà la risposta ad una richiesta trasmessa su quella determinata rete. Risulta evidente che dispositivi collegati tra di loro tramite strutture che hanno limiti di velocità di trasmissione differenti influenzano la velocità complessiva di trasmissione in tutto il collegamento. Vedremo come sia importante questo punto per comprendere altri concetti che prenderemo in esame più avanti. |

|

Risoluzione e Pixel

Un’altra unità di misura in informatica che nella Cultura digitale ha assunto un ruolo molto importante è il pixel che è l’unità di base utilizzata nell’informatica per definire la qualità di un’immagine rappresentata sullo schermo di un monitor, sulla carta stampata con strumenti digitali, impressa sui sensori digitali di una fotocamera digitale. Con il termine pixel (dall’inglese picture element) si indica ciascuno degli elementi puntiformi che compongono la rappresentazione di una immagine digitale nella memoria di un computer Solitamente i punti sono così piccoli e numerosi da non essere distinguibili ad occhio nudo, apparendo fusi in un'unica immagine quando vengono stampati su carta o visualizzati su un monitor. Ciascun pixel, che rappresenta il più piccolo elemento autonomo dell'immagine, si imprime nella memoria di un computer con la proprie coordinate geografiche all’interno di una griglia e con valori, quali colore e intensità, variabili in funzione del sistema di rappresentazione adottato. Risulta evidente che più pixel sono usati per rappresentare un'immagine, più il risultato assomiglierà all'immagine originale. Il numero di pixel con il quale si rappresenta un'immagine è detta Risoluzione. Pertanto la risoluzione di un’immagine indica il grado di qualità di un’immagine. La qualità di un’immagine, pertanto, è direttamente proporzionale alla densità di pixel con cui è rappresentata. La densità di pixel relazionata in base allo spazio si misura in “Pixel per Inch” o “Dot per Inch” [DPI] La risoluzione di un’immagine, può essere espressa in due modi. Può essere misurata in DPI, espressi in funzione della larghezza e dell’altezza della superficie su cui si imprime l’immagine, carta o schermo che sia. Oppure da un solo numero che esprime il numero di pixel complessivo che costituisce l’immagine. Ad esempio, la risoluzione dell’immagine televisiva trasmessa con lo standard PAL in uso in Italia equivale ad una risoluzione di DPI 768x576, una risoluzione ad Alta Definizione [HD] di cui tanto si sente parlare equivale ad una risoluzione DPI 1980x1080 |